Как запустить А/Б тест

А/Б тесты — мощный инструмент маркетолога. Они помогают постоянно улучшать коммуникацию с посетителями сайта: тестировать и выбирать те элементы, которые с большей вероятностью убедят их совершить целевое действие, например, покупку. В этой статье мы расскажем, что такое А/Б тесты, зачем они нужны, как правильно их проводить и анализировать результаты.

Руководитель команды внедрения Carrot quest Женя Аликин постоянно проводит А/Б тесты для наших клиентов. Он поделился своим опытом и интересными кейсами на вебинаре. Про некоторые из них мы написали в статье, остальные можно посмотреть в записи:

Что такое А/Б тесты и зачем они нужны

![]() А/Б тест — это эксперимент для оценки эффективности отправляемого сообщения. В ходе А/Б теста сравнивают эффективность разных сообщений, каналов коммуникации или элементов сайта, чтобы выяснить, какие изменения улучшают целевой показатель.

А/Б тест — это эксперимент для оценки эффективности отправляемого сообщения. В ходе А/Б теста сравнивают эффективность разных сообщений, каналов коммуникации или элементов сайта, чтобы выяснить, какие изменения улучшают целевой показатель.

Зачем делать А/Б тесты:

1. Быстрее проверять гипотезы.

Вас не устраивает конверсия в заявку на лендинге. Предположим, что его полная переделка займет месяц, потребует участия целой команды и не гарантирует изменений в конверсии. А если вы проведете А/Б тест отдельных элементов, то увидите изменения уже через одну-две недели, и этот процесс потребует значительно меньше ресурсов. Мы подробно рассказали про тестирование маркетинговых гипотез в отдельной статье.

2. Принимать решения на основе данных.

Вносите изменения, которые подсказывают подтвержденные данные, а не интуиция. Вы можете проверять любые элементы страницы и видеть по результатам А/Б теста, какой вариант лучше остальных на основе статистики.

3. Получать полезные инсайты.

А/Б тесты помогут понять целевую аудиторию и узнать, как с ней лучше работать. Те каналы коммуникации и ценности, на которые вы рассчитывали больше всего, могут попросту не сработать.

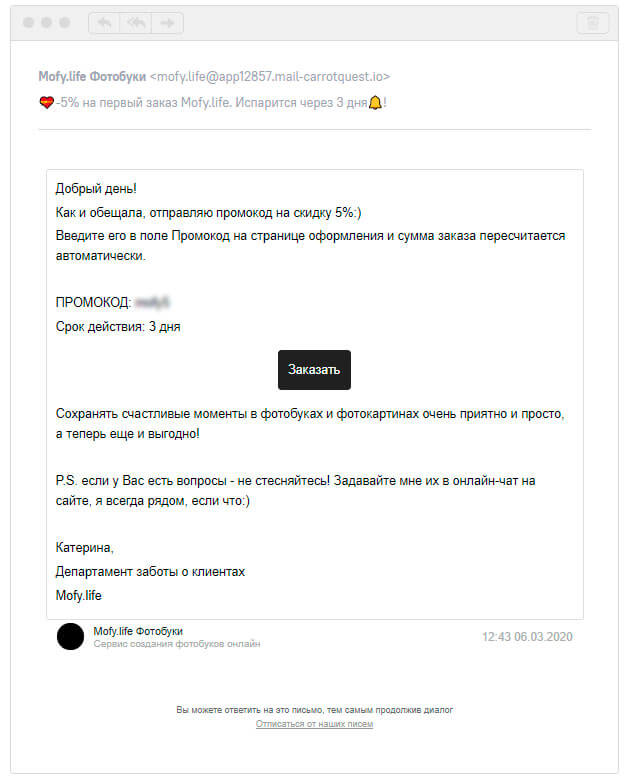

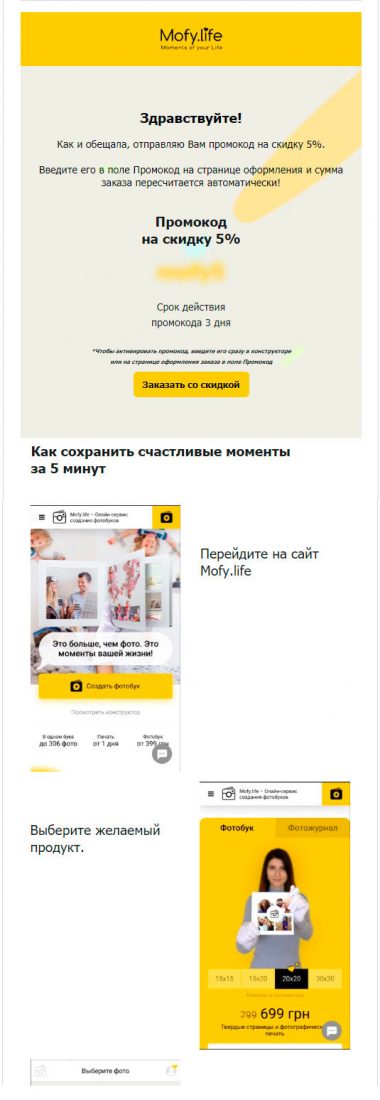

Например, на сайте онлайн-сервиса по созданию фотобуков Mofy.life протестировали два варианта писем:

- лаконичный, с минимальным количеством информации и без демонстрации продукта:

- яркий, с анимацией и пошаговой инструкцией по оформлению заказа:

Удивительно, но CTR обычного письма оказался выше: 13,63% против 9,92%.

Почему нельзя отправить всем сначала одно письмо, а через неделю другое, и сравнить результат

А/Б тесты помогают исключить влияние внешних факторов вроде сезонности, рекламных кампаний и дней недели.

Например, вы провели успешную рекламную кампанию и привели на сайт заинтересованных в продукте лидов. Будет некорректно сравнивать эффективность сообщения, которое отправили этой группе, с эффективностью сообщения, которое отправили в другое время для нецелевого или совсем холодного трафика. Точный результат можно получить, если учесть и минимизировать влияние подобных внешних факторов.

Сообщения показываются в один и тот же период времени, а люди в каждую из групп (А или Б) выбираются случайным образом.

Что можно тестировать

Всё, что может влиять на поведение пользователей. Чаще всего А/Б тесты применяют для оптимизации емейл-рассылок, поп-апов, сообщений в чат.

Что можно протестировать:

- тему письма;

- текст сообщения;

- изображения;

- расположение блоков с контентом в письме;

- текст на кнопках;

- призывы к действию;

- каналы коммуникации.

В первую очередь протестируйте ценности для клиента и общие формулировки. Такие тесты быстрее дадут статистически значимый результат и покажут разницу в конверсии. Для роста важнее ценность, которую вы предлагаете, а не кнопки и шрифты.

Лучше не тестировать мелочи вроде цвета кнопок, потому что на получение значимого результата у вас уйдут месяцы. За время такого теста продукт или сайт могут измениться, и тест потеряет свою актуальность еще до того, как вы получите результат.

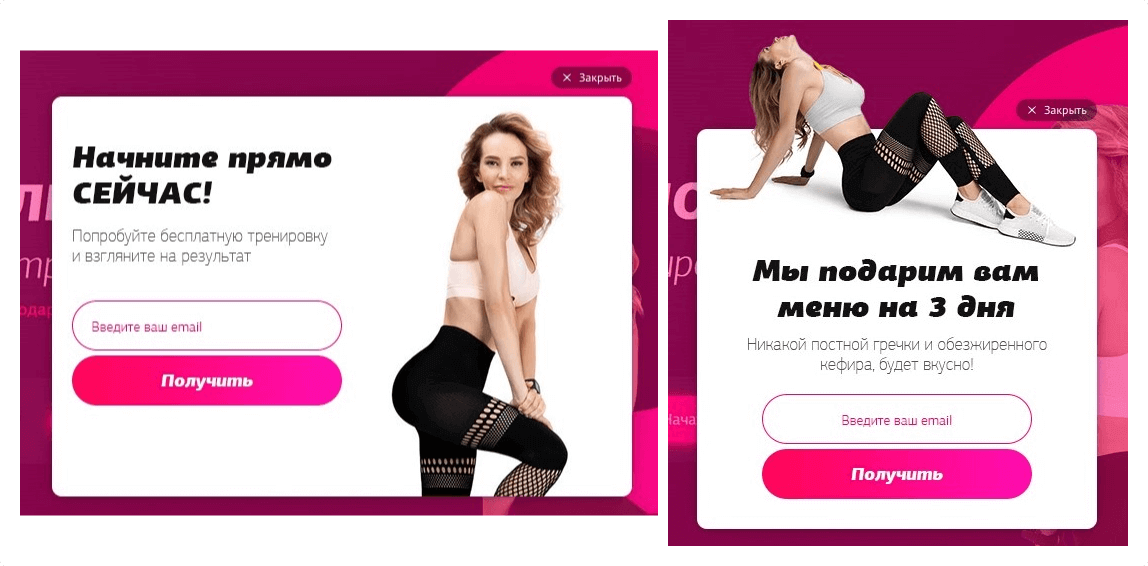

В одном проекте мы тестировали оффер на сайте курсов по улучшению фигуры. В первом варианте пользователю предлагали бесплатную тренировку, а во втором — меню на три дня:

Конверсия варианта А — 3,91%, варианта Б — 6, 34%, это значительная разница. Мы предполагаем, что второй вариант оказался эффективнее по двум причинам:

- Мы все любим есть. Вкусное меню ценнее, чем очередная тренировка.

- Выгода в заголовке. Многие не читают дальше заголовка, поэтому лучше в нем прописать ценность.

Примеры А/Б тестов

Здесь мы собрали примеры А/Б тестов, которые проводила команда внедрения Carrot quest для наших клиентов.

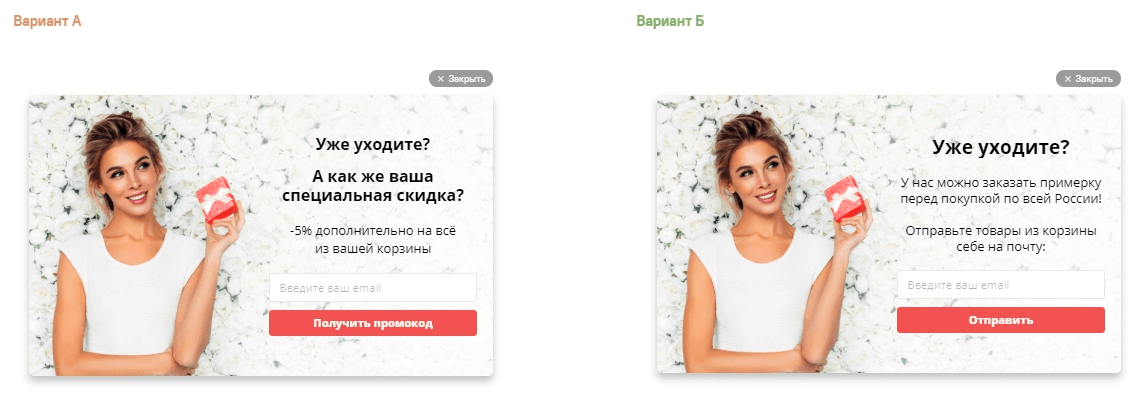

1. Поп-апы на сайте интернет-магазина одежды:

Конверсия первого поп-апа — 1,75%, конверсия второго меньше в 10 раз — 0,18%.

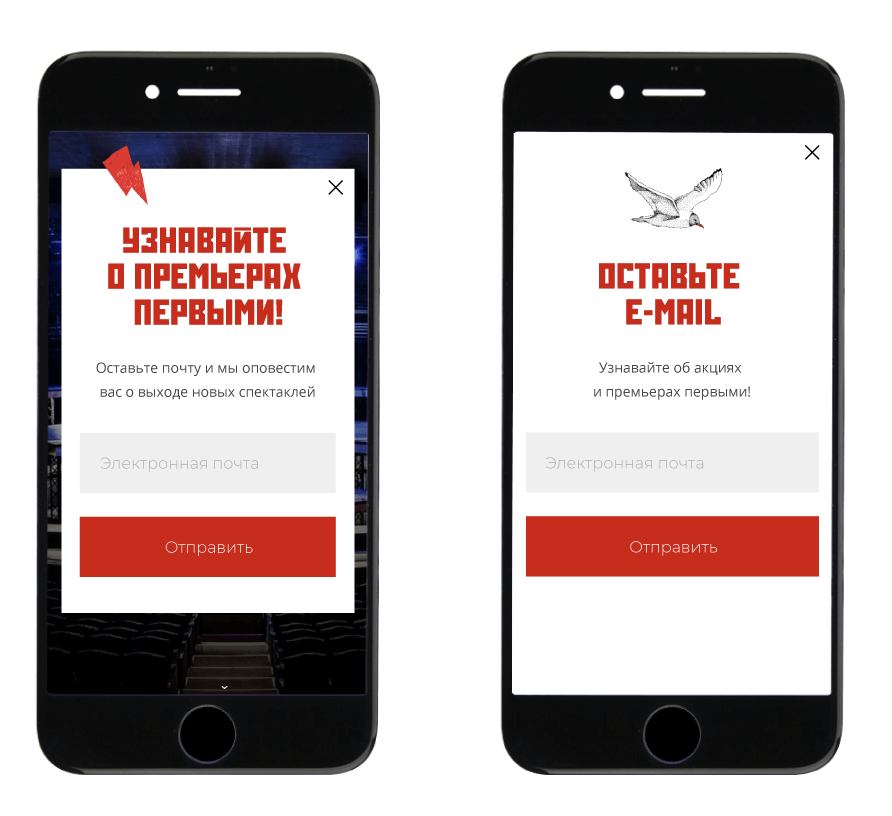

2. На сайте Театр-Театра протестировали два варианта поп-апа.

В варианте А оффер показывает ценность, а в варианте Б — сразу подталкивает к действию:

Конверсия в емейл у первого поп-апа составила 1,16%, а у второго — 4%. Поп-ап с призывом к действию работает лучше, потому что пользователи сразу понимают, чего от них хотят, и легче оставляют емейл.

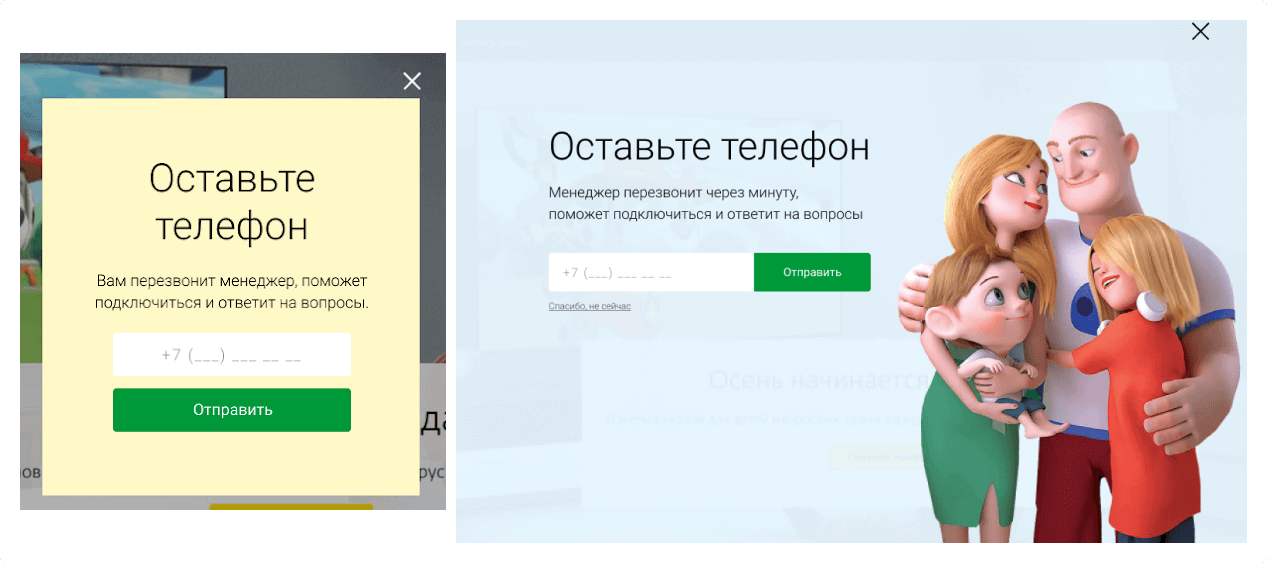

3. Поп-апы, которые собирают номера телефонов на сайте крупного интернет-провайдера:

Поп-ап со счастливым семейством лучше привлекает внимание. Его конверсия в телефон составила 3,1% против 2,18% у небольшого поп-апа.

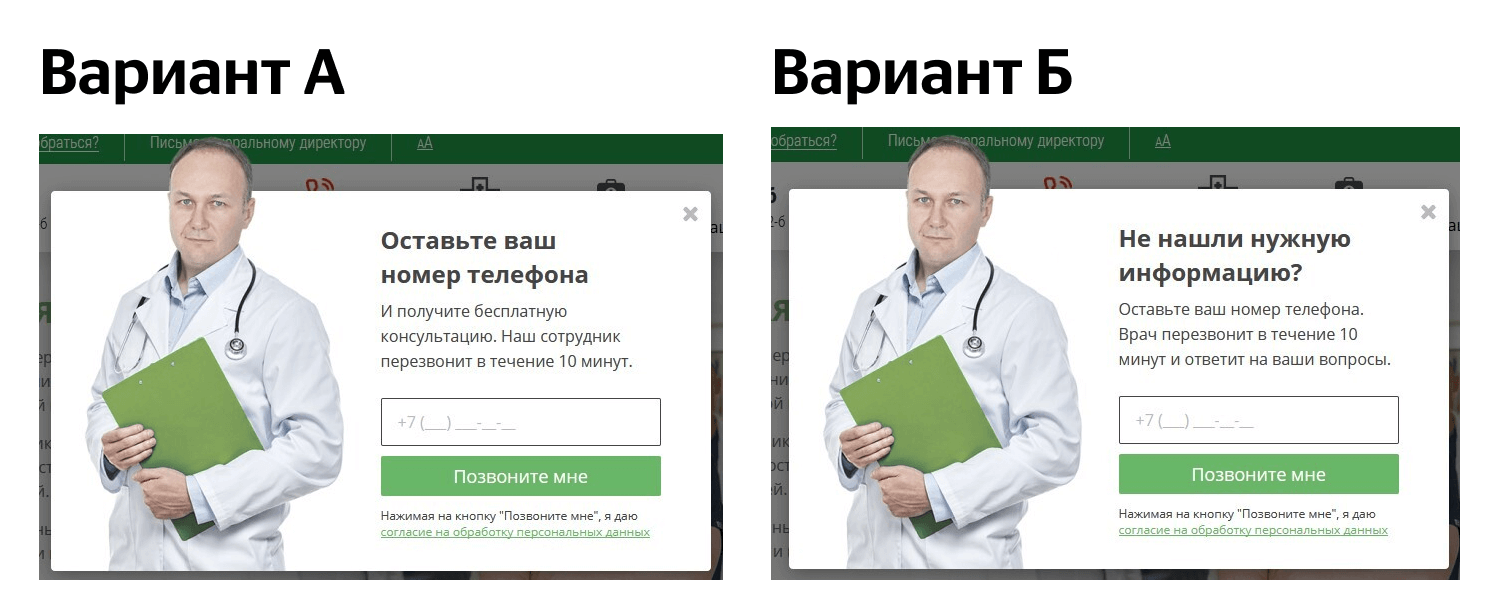

4. Поп-апы на сайте клиники:

Конверсия в телефон у первого поп-апа — 0,44% против 0,25% у варианта Б. Чаще всего люди не читают мелкий текст, поэтому призыв к действию должен быть заметен.

Как определить, сколько времени займет А/Б тест

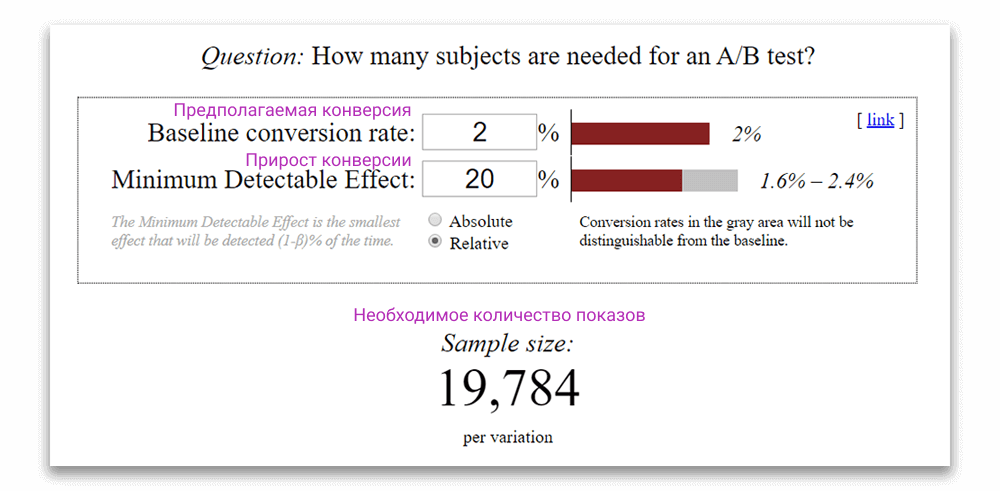

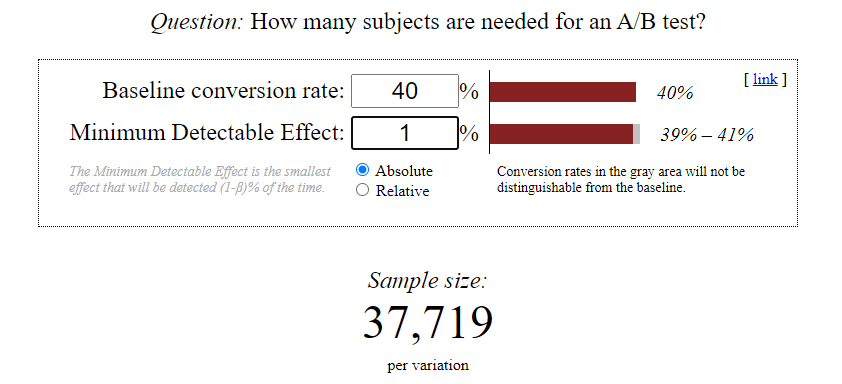

Оценивать А/Б тесты можно с помощью калькулятора Эвана Миллера. Чтобы понять, сколько времени займет А/Б тест и стоит ли его проводить, вам понадобится информация о:

- трафике на сайте,

- текущей конверсии,

- предполагаемом приросте конверсии.

С помощью калькулятора Эвана Миллера вы сможете рассчитать количество показов, необходимое для получения статистически значимого результата. Если соотнести количество показов с примерным трафиком на сайте, можно определить, сколько времени займет А/Б тест и стоит ли его проводить.

Если А/Б тест потребует слишком много времени, лучше его не запускать: ваше предложение может измениться, а время и силы будут потрачены впустую. Поменять цвет кнопки, ждать 6 месяцев и получить разницу в конверсии в 0,5% — очень сомнительное удовольствие и не позволит проекту кратно расти.

Бывают А/Б тесты, которые проводят от нескольких месяцев до полугода, и они тоже могут окупиться, если компания продает товары с высоким ценником. Например, покупка одного автомобиля или загородного дома часто окупает полугодовые или годовые затраты на автоматизацию маркетинга.

Предположим, что трафик на сайте — 50 тысяч пользователей в месяц. Вы тестируете два варианта поп-апа со сбором емейлов.

- предполагаемая конверсия поп-апа — 2%;

- ожидаемый прирост конверсии — 20%;

- То есть конверсия поп-апа в одном из вариантов может увеличиться до 2,4%.

Вносим данные в калькулятор. Он рассчитал, что на каждый из вариантов нужно 19 784 показов:

Вычитаем часть аудитории сайта, которой не хотим показывать сообщение. Например, текущие клиенты — у них мы уже знаем емейл.

Остаётся 45 тысяч пользователей.

Нужно 19 784*2 показов.

Получается, что на этот тест понадобится месяц.

Пример А/Б теста, на проведение которого понадобится 21 год:

Предположим, трафик на сайте — 10 тысяч человек, конверсия в email — 3%. Вы хотите провести А/Б тест темы письма, чтобы понять, влияют ли эмодзи на Open Rate — отношение количества открытых писем к количеству отправленных.

Вариант А: Дарим 5000 рублей на ваш заказ!

Вариант Б: Дарим 5000 рублей на ваш заказ!

По результатам теста вы видите:

Open rate варианта А — 40%

Open rate варианта Б — 41%

Получается, что эмодзи незначительно влияют на конверсию.

Вводим эти данные в калькулятор:

Нам нужно будет отправить 37 719 писем на каждый из вариантов, чтобы понять, действительно ли эмодзи влияют на конверсию. Это 75 438 писем.

- При конверсии в емейл 3% и трафике в 10 тысяч человек вы сможете отправлять 300 писем в месяц.

- Получается, что на принятие решения по этому А/Б тесту вам понадобится 21 год.

Как провести А/Б тест

- Определите метрику, на которую вы будете ориентироваться. Это может быть коэффициент конверсии, показатель кликабельности (CTR), количество регистраций.

- Разработайте гипотезу о том, что именно поменяется, и каких результатов вы ожидаете.

- Подготовьте эксперимент:

- Создайте две версии сообщения/поп-апа/письма;

- Решите, на каких пользователях вы будете проводить эксперимент, а какие будут в контрольной группе — части аудитории, которая не увидит ни один из вариантов. Это поможет определить, что происходит с конверсией без вашего сообщения;

- Посчитайте минимальный размер выборки с помощью калькулятора;

- Определите продолжительность А/Б тестирования.

- Проведите эксперимент.

- Проанализируйте результаты.

- Проверьте статистическую значимость с помощью калькулятора, чтобы не делать ошибочных выводов. Чем она ниже, тем больше вероятность, что полученные вами результаты — случайность.

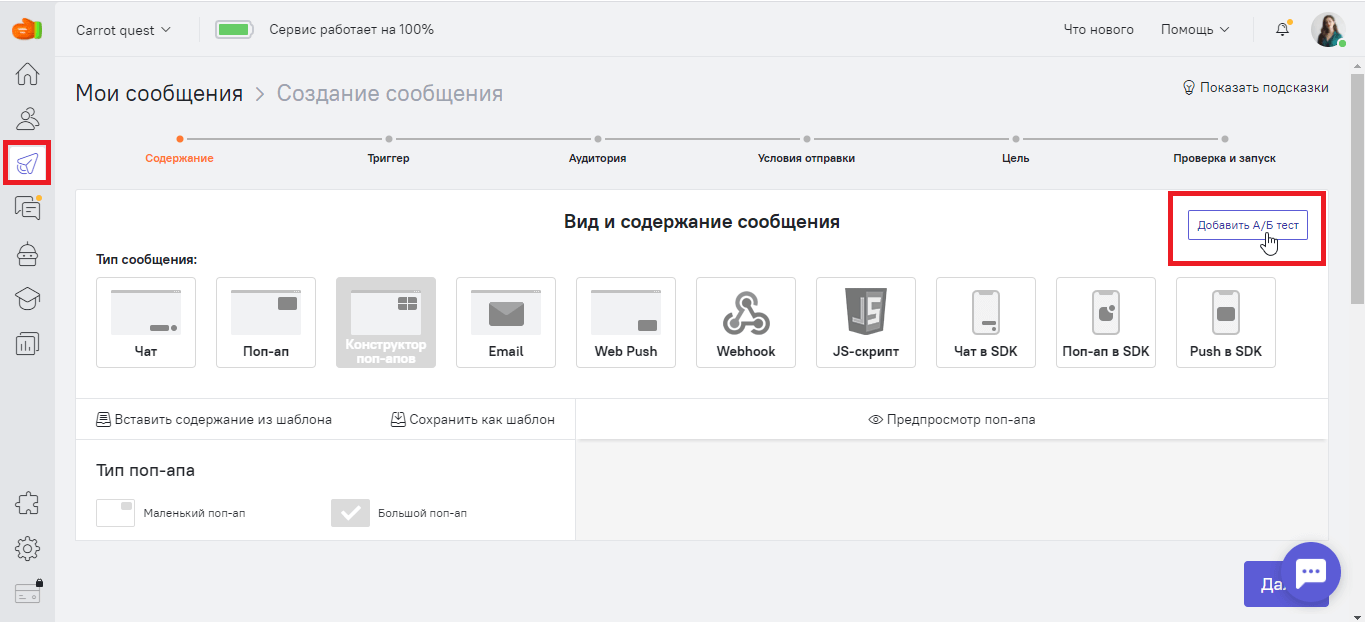

Как запустить А/Б тест в Carrot quest

Зайдите в раздел «Триггерные сообщения», нажмите на кнопку «Создать сообщение» и выберите нужный тип. Создайте первый вариант сообщения нажмите на кнопку «Добавить А/Б тест»:

Ещё один вариант: вы можете выбрать уже существующее триггерное сообщение и создать для него А/Б тест.

После этого откроется раздел, в котором вы сможете сделать второй вариант. Carrot quest сам разделит аудиторию сообщения на две равные группы и покажет каждой свой вариант. Дальше вы ждете, когда в статистике сообщения наберется достаточно данных. В зависимости от трафика, на это может потребоваться от нескольких дней до нескольких месяцев.

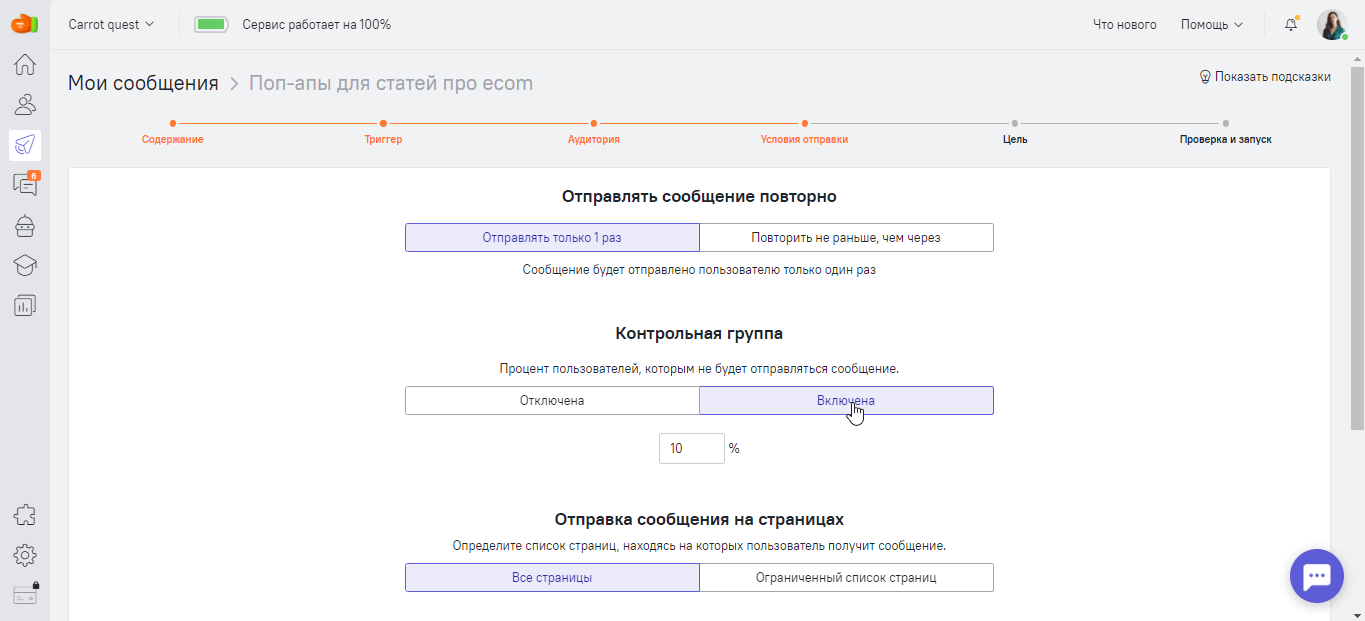

В разделе «Условия отправки» вы можете включить контрольную группу. По умолчанию она составляет 10% — это значит, что 10% посетителей сайта не увидят ни варианта А, ни варианта B. Вы можете задать своё значение. Но помните, чем меньше процент контрольной группы, тем дольше вы будете ждать, пока соберется статистика.

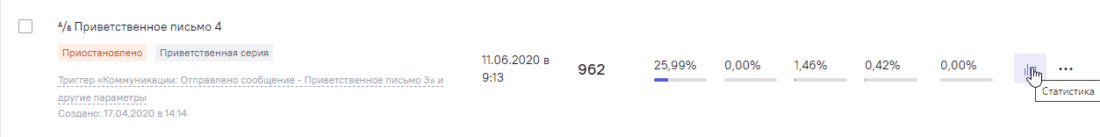

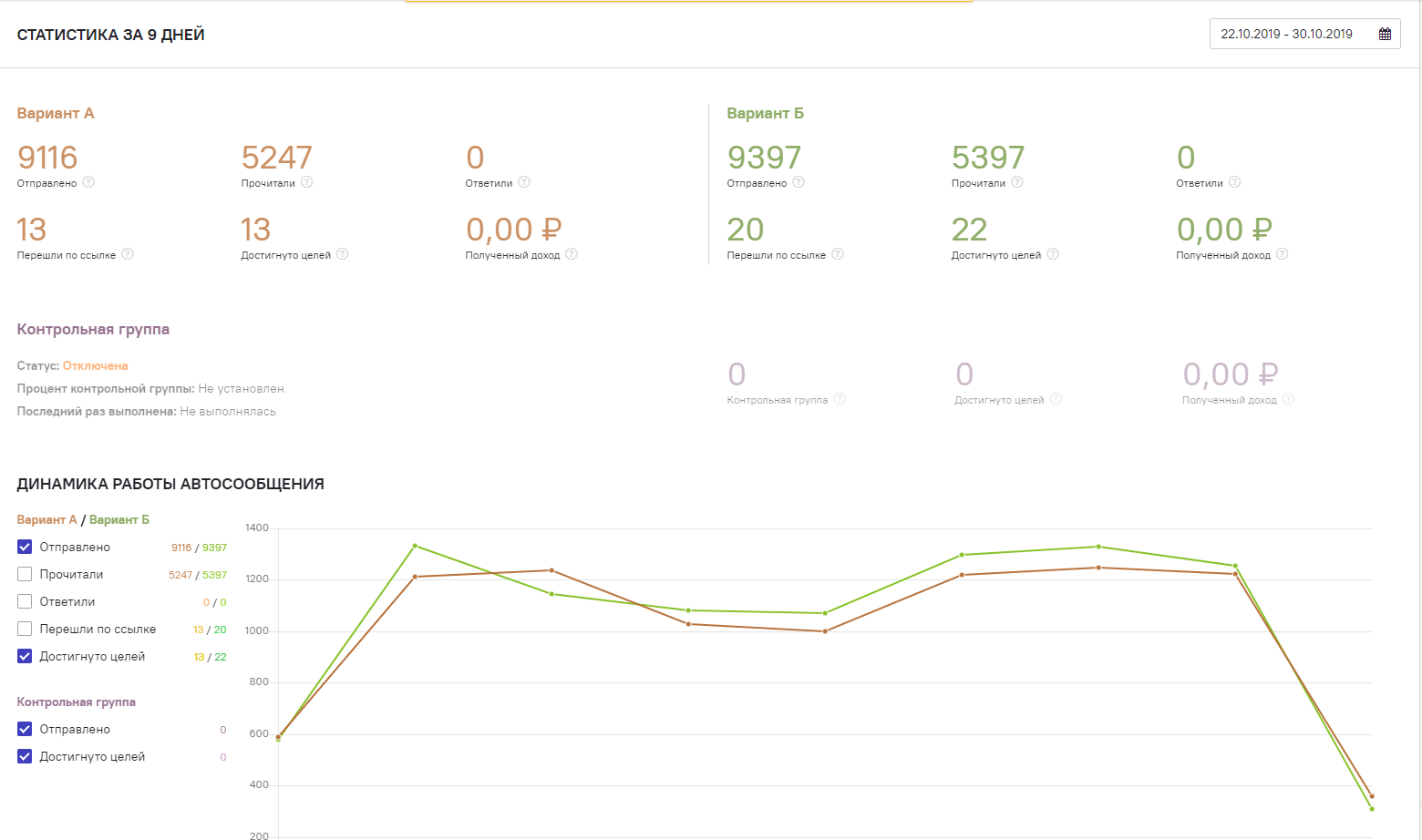

Чтобы узнать, какой вариант сработал лучше, кликните на иконку «Статистика» и перейдите в раздел «А/Б тест»:

Вы можете посмотреть:

- количество отправленных сообщений;

- сколько из них было доставлено и прочитано;

- на сколько из них ответили, в скольких перешли по ссылке;

- сколько человек пожаловались на спам и отписались.

Данные выводятся рядом, чтобы вы могли сравнить цифры, а также в виде графиков:

Вы можете посмотреть, сколько денег принёс вам каждый из вариантов. Для этого при настройке автосообщения задайте цель (следующий шаг после Вид и Содержание). Это событие, которое должен выполнить пользователь после прочтения автосообщения (например, купить). В статистике вы сможете увидеть конверсию достижения цели и полученный доход.

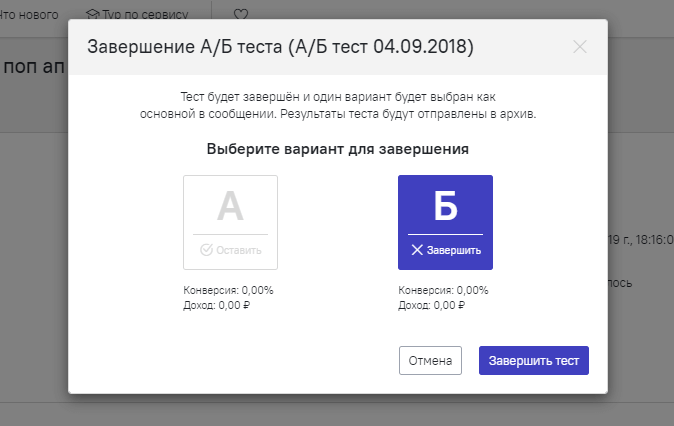

Как только вы набрали достаточно статистических данных и выбрали сообщение-победителя, завершите А/Б тест. Для этого нажмите кнопку «Завершить тест» и выберите вариант сообщения, который хотите отключить:

Как только вы снова решите сравнить сообщение А с каким-либо другим, создайте новый А/Б тест на основе этого же сообщения. У одного сообщения может быть неограниченное количество А/Б тестов. Историю всех закрытых А/Б тестов можно посмотреть в архиве.

Посмотрите нашу видеоинструкцию о том, как запустить A/Б тест в Carrot quest:

Как оценивать результаты А/Б тестов

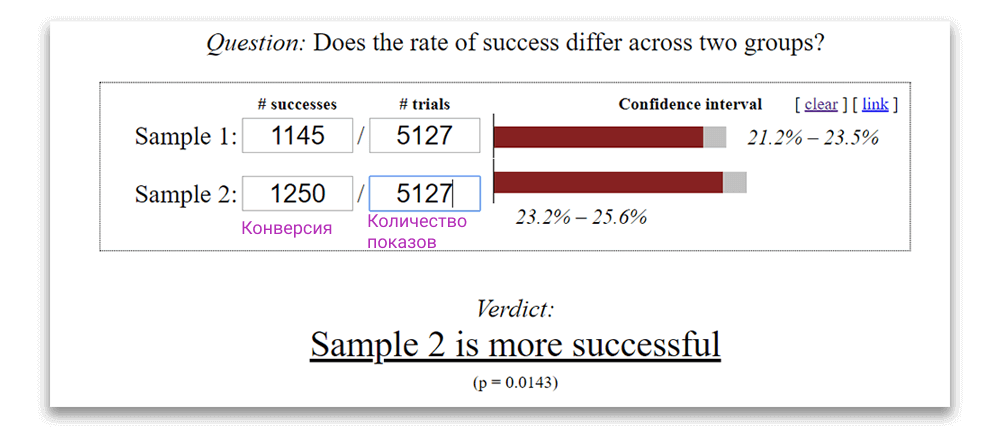

Чтобы понять, какой из вариантов был успешнее, воспользуйтесь калькулятором Эвана Миллера. Внесите в калькулятор количество показов и конверсию каждого из вариантов.

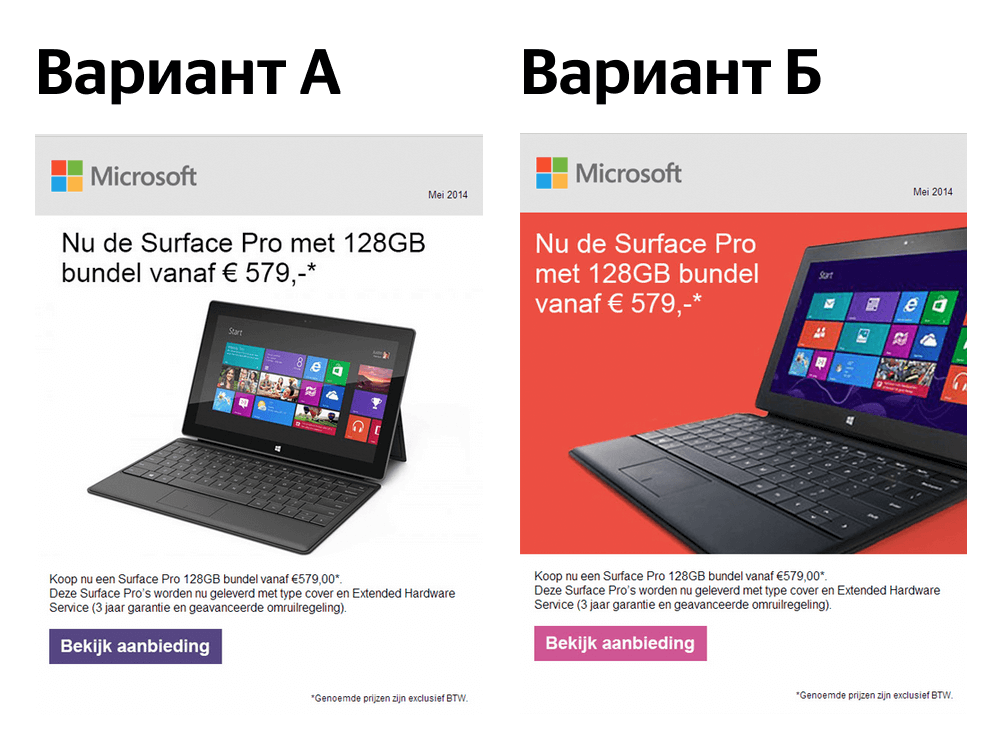

Допустим, вы запускаете А/Б тест с гипотезой о том, что новая цветовая гамма письма увеличит количество кликов:

В результате вариант А открыли 5127 раз, переходов было 1145. У варианта Б такое же количество открытий, а переходов — 1250. Калькулятор выдает результат, что вариант Б победил:

Важно, чтобы тестируемый элемент влиял на целевое действие: регистрацию, оплату или оставленный лид. Правильнее всего оценивать эффективность А/Б теста именно по этим параметрам.

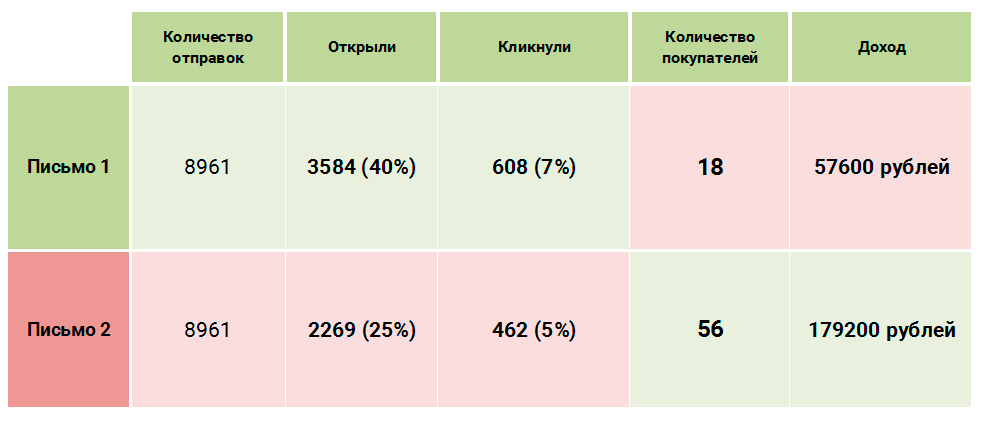

Какое из писем стоит признать победителем в А/Б тесте?

Несмотря на то, что пользователи лучше взаимодействуют с первым письмом, второе принесло больше продаж и, как следствие, денег. Открытия и клики — это здорово, но смотрите на конверсию в те действия, которые важны для бизнеса.

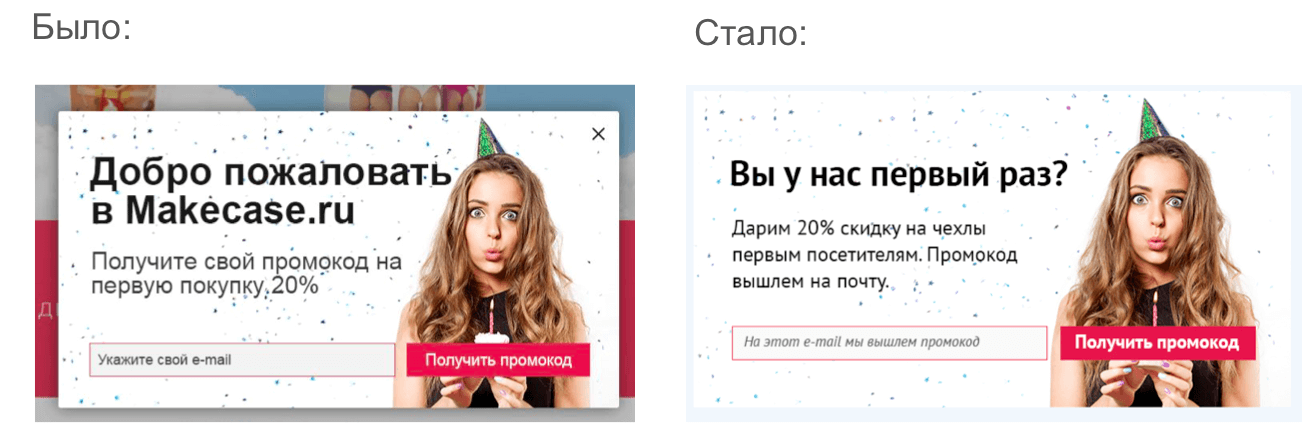

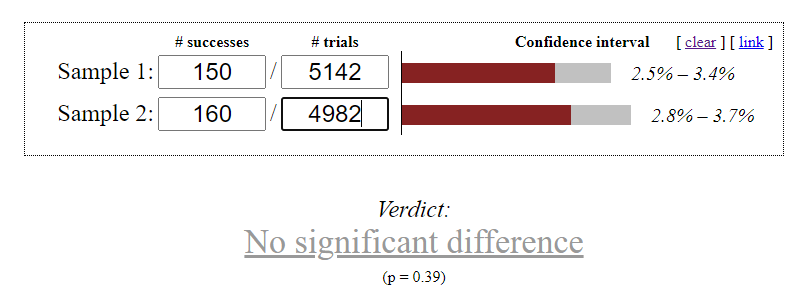

Бывает, что статистически значимого результата по А/Б тесту нет. Например, мы тестируем два поп-апа с разными текстами:

Вариант А: собрано 150 емейлов, 5142 показа, вариант Б: собрано 160 емейлов, 4982 показа:

В этом примере мы не получили статистически значимых данных, поэтому можно оставить любой из вариантов.

Какие еще бывают тесты

Если вы уже проверили все гипотезы и стандартных А/Б тестов оказалось недостаточно, присмотритесь к другим вариациям:

- А/А тест. На два сегмента запускается один месседж, чтобы проверить однородность трафика и качество настройки сплит-тестирования. Используется как подготовка к А/Б тесту, но занимает много времени.

- А/А/Б тест. Запускается, когда есть подозрение на то, что на определенной выборке трафик недостаточно однородный, и сегмент Б даст достоверный результат, только когда А и А будут равны.

- А/Б тест с контрольной группой. Тестирование, при котором аудитория делится на три части: 45% аудитории увидят вариант А, 45% увидят вариант Б, 10% не увидят ничего. Это нужно, чтобы выяснить, как сообщение влияет на пользователя. Если контрольная группа конвертируется так же или лучше остальных, это звоночек, что А/Б тест лучше закрыть.

Топ-5 ошибок при проведении А/Б тестов

1. Отсутствие сегментации пользователей

Сегментация — это основа любой кампании по автоматизации маркетинга. Важно, чтобы клиенты получали релевантные сообщения. В противном случае А/Б тест может дать ошибочный результат, так как проигравшее на общей массе пользователей сообщение может оказаться выигрышным среди целевой аудитории.

Что еще можно почитать о сегментации:

- Превращайте новичков в самых активных пользователей с помощью сегментации по жизненному циклу

- 4 техники лидскоринга, которые вы можете использовать в автоматизации маркетинга

- Как за 3 шага определить «горячих» лидов, чтобы сделать продажу и почему 95% компаний этого не умеют

2. Слишком маленькая аудитория для А/Б теста

Чем больше аудитория для А/Б теста, тем надежнее будет результат. Если в тесте приняли участие 4 человека, то голос каждого из них — это 25%. А если участников было 400 или 4 000, то данные можно считать репрезентативными.

3. Слишком много экспериментов в одном

Суть А/Б теста в том, чтобы выяснить, как влияет изменение конкретного элемента на конверсию в целевое действие. Поэтому важно менять не больше одного элемента за раз. Иначе вы не сможете сказать, что повлияло на успех письма: котик на картинке вместо собачки, большая красная кнопка CTA вместо простой текстовой ссылки, более удачная тема письма или всё сразу.

В Carrot quest для одного автосообщения вы можете последовательно настраивать неограниченное количество А/Б тестов. Например, сначала вы можете протестировать заголовок письма. Как только определите победителя и закончите тест, можете переходить к тестированию CTA, а затем текста сообщения.

Спасибо! Мы отправим всё на почту.

Вам подарок — бесплатный аудит вашего сайта. Подскажем, как собирать больше лидов без увеличения рекламного бюджета.

Заказать консультацию

4. Надежда на чужой опыт

Некоторые маркетологи хотят обмануть всех и не проводить А/Б тест, а посмотреть результаты чужого кейса и внедрить сразу успешный вариант. Это большая ошибка, потому что отличается буквально всё. Только тест покажет, что работает в вашем случае, для вашей аудитории.

Вы с удивлением можете обнаружить, что у вас лучше работает зелёная кнопка, хотя только вчера прочитали кейс, где компания отказалась от зеленого в пользу красного и увеличила продажи в 2 раза. Это нормально. Верьте собственным данным.

5. Завышенные ожидания

Этот пункт связан со всеми предыдущими. Многие смотрят на успешные кейсы других компаний и считают, что А/Б тесты непременно повысят конверсию если не в два раза, то хотя бы на 30-40%. В реальности совсем не обязательно будет так. Разница в результатах может быть невелика, но даже она влияет на количество лидов или прибыль.

Запаситесь терпением. Ваш первый А/Б тест может не привести к росту конверсии, но не спешите отказываться от этого инструмента. Смысл в том, чтобы постоянно тестировать разные элементы, постепенно улучшая коммуникацию с пользователями и повышая конверсию шаг за шагом.

Статья впервые опубликована 14 июня 2017. 12 января 2021 года статья была обновлена.

Больше про А/Б тесты:

Подпишитесь на рассылку Carrot quest

1 письмо в неделю со свежими материалами о маркетинге, под�держке и продажах

Нажимая на кнопку, вы даете согласие на обработку персональных данных